GPT 跟你分享的 AI 心理諮詢使用須知

張誌閔

2025-06-06更新

2025-04-10發佈

# 心理諮詢

# 心理諮商

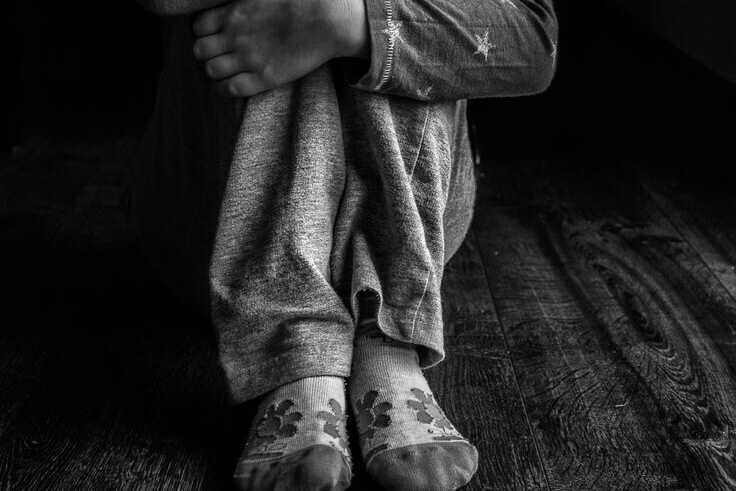

這段時間在講座與工作場合中,常聽到民眾分享自己會和 AI 聊天談心,獲得即時陪伴支持。然而,這種新興的心理服務形式對多數人而言仍相當陌生。我們享受 AI 帶來的便利,卻未必理解其中潛藏的風險。

快速跳轉目錄

GPT 跟你分享的 AI 心理諮詢使用須知

這段時間在講��座與工作場合中,常聽到民眾分享自己會和 AI 聊天談心,獲得即時陪伴支持。然而,這種新興的心理服務形式對多數人而言仍相當陌生。我們享受 AI 帶來的便利,卻未必理解其中潛藏的風險。

陳宏儒是一位長期關注心理治療與心理健康應用的心理師。在閱讀他的分享後,意識到AI 在心理諮詢上的應用,確實存在許多值得關注的倫理議題與使用須知。

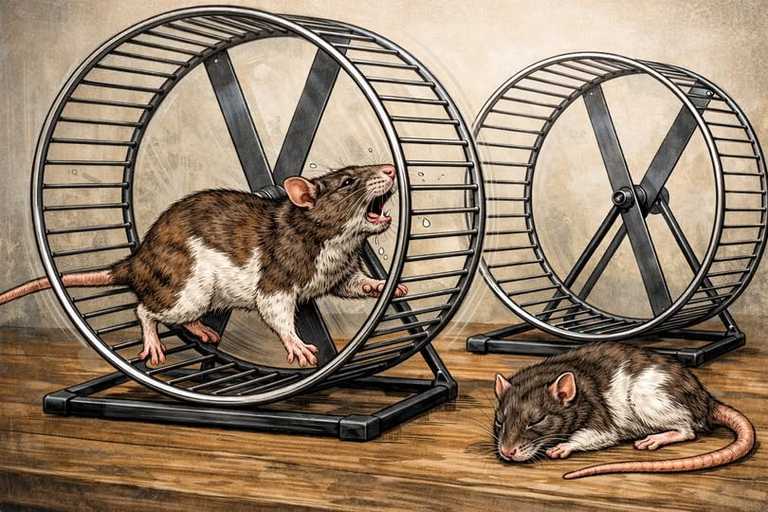

目前,我們尚無法全面預測過度依賴 AI 心理陪伴所可能帶來的風險。但從過去網路成癮與沉迷的治療經驗來看,任何事物的濫用都可能伴隨代價。現階段,社會普遍仍將 AI 視為輔助工具,其功能不宜取代現實生活中的人際連結與心理支持。

以下是透過 GPT 協助整理的 AI 心理諮詢使用須知:

Ai心理諮詢使用前須知-Ai基於倫理守則,有其內建的保護機制

AI在「心理互動安全設計」方面,雖然尚未有統一的標準或架構,但目前主流AI內建了一些基礎的機制來嘗試維護使用者的心理安全。

🔐 一、內容過濾與敏感識別(Content Moderation)

AI會自動辨識並過濾高風險或可能造成心理傷害的內容,例如:

自殺、自殘、暴力等相關語言

對使用者有貶損、羞辱、歧視等負面言語

鼓勵傷害自己或他人的建議

這是一種「預防性介入」,避免AI無意間引發心理危機。

🧠 二、非診斷性互動規則(Non-diagnostic Boundary)

AI不提供醫療或心理診斷,也不該取代人類心理師。這樣的設計目的是:

避免使用者對AI產生過度依賴或誤信其專業能力

減少AI在使用者心理脆弱時給出不當建議的風險

這種界線的設定,是一種對「助人關係倫理」的數位翻譯。

🫂 三、情緒辨識與支持語言(Emotional Sensitivity)

有些AI系統會嘗試辨識語言中的情緒線索(如焦慮、悲傷、憤怒),並給予:

同理性的回應(empathic response)

情緒調節建議(如深呼吸、寫日記)

鼓勵尋求人際連結或專業協助

這可視為一種「情感陪伴式的設計」,強調關係的溫度。

🔄 四、責任分流與轉介機制(Escalation & Referral)

當使用者表達嚴重心理困擾時(如明確提及想死),AI通常會:

表達關切,避免直接討論方法細節

引導使用者尋求危機專線或專業幫助

終止對話或改變互動方式以減少風險

這是一種「最低傷害原則」(Principle of Least Harm)的落實。

🛠️ 五、人機互動透明化(Transparency & Control)

許多AI設計會提供:

回饋機制(例如使用者可標記不當回應)

互動記錄(方便人類審查與調整)

對話結束選項(賦予使用者控制權)

這在某種程度上,是將倫理的「自決」與「知情選擇」搬進對話空間中。

────

除了上述內建機制,我們在使用上應採取什麼自我保護措施

🧭 AI心理互動安全守則與明確做法

🧠 一、認識 AI 的角色與限制

原則:AI 是輔助工具,不是心理師,也不是真朋友。

具體做法:

✅ 使用前先提醒自己:「AI沒有感情,它的建議只是文字預測結果。」

✅ 詢問AI時加上「請以非專業建議的方式提供建議」。

✅ 若覺得AI的話語過於肯定或判斷性太強,停下來自問:「這是我真正的感受嗎?」

🧘♀️ 二、保護自己的情緒安全

原則:你永遠可以中止、不回應、或選擇離開對話。

具體做法:

✅ 對話過程中,若�出現以下狀況可暫停對話:

心情變得更沉重

感覺被誤解

出現身體壓力反應(胸悶、頭痛、煩躁)

✅ 對話後,給自己5分鐘安靜時間,覺察:「這段對話帶來了什麼感受?」

🛑 三、設立對話邊界

原則:你有權決定聊什麼、聊到哪裡、什麼時候不聊。

具體做法:

✅ 在對話開頭,清楚說出需求: 「我今天只想聊聊最近壓力的感覺,不想分析太深。」

✅ 遇到不想回答的提問,直接輸入: 「這部分我現在不想談,謝謝。」

✅ 若AI的語氣讓你不舒服,可以輸入: 「請改用較溫和的方式回應。」

🔐 四、保護個人隱私與資料 原則:不要透露敏感資訊,避免被誤用或識別。

具體做法:

✅ 使用匿名帳號與平台互動。

✅ 不輸入真實姓名、電話、住址、身分證字號等資訊。

✅ 不談特定第三人(如家人姓名、住址、個資),避免牽涉他人隱私。

✅ 若對平台的資料政策不確定,選擇簡短回應或改用紙筆自我反思。

🛠 五、善用 AI 的優點,避免過度依賴

原則:AI 是你的思考陪伴者,不是決策者或情緒寄託。

具體做法:

✅ 將AI作為「提問的鏡子」來使用,例如: 「請幫我從不同角度問出這個情緒背後的意義。」

✅ 每週與AI互動不超過1小時,避免沉迷或過度依附。

✅ 對重要情緒議題,與朋友、心理師、人類支持者進行實際對話。

✅ 可搭配書寫、畫畫、靜坐、運動等方式整合對話帶來的啟發。

💬 附加工具(選用)

記錄感受 ,使用情緒日記 App(如 Moodnotes、Daylio)

中斷對話 設定「安全詞」:輸入「停止對話」AI應結束回應

事後整理:用AI總結對話重點,幫助反思,不帶評價